Spätestens seit dem unerwarteten Wahlsieg von Donald Trump hat die Diskussion zur Meinungsmanipulation im Internet, etwa über Fake News oder Social Bots, neue Höhen erreicht. Doch eindeutige Diagnosen gibt es nicht – und erst recht keine einfachen Lösungen.

Es ist das Trendthema schlichthin. Als ein Gremium von Sprachwissenschaftlern Anfang des Jahres die „Anglizismen des Jahres” kürte, landete der Begriff Fake News auf dem ersten Platz, gefolgt von Darknet und Hate Speech. Der Bundestag veranstaltete gleich zwei Fachgespräche zu Social Bots, die in den Wahlkampf eingreifen könnte. Und Facebook gelobte, neue Maßnahmen gegen die Verbreitung falscher Nachrichten zu ergreifen.

Die Lage ist alarmierend und unklar

Haben Fake News und andere Manipulationen im Internet gar den knappen Ausgang der US-Wahlen entschieden? Das weiß niemand so genau. Wahlforscher tun sich schwer, das Thema zu fassen. So weist der amerikanische Statistik-Experte Nate Silver darauf hin, dass sich der Einfluss der über Monate aggressiv verbreiteten Fake News kaum von der allgemeinen Stimmung und anderen Faktoren trennen lässt.

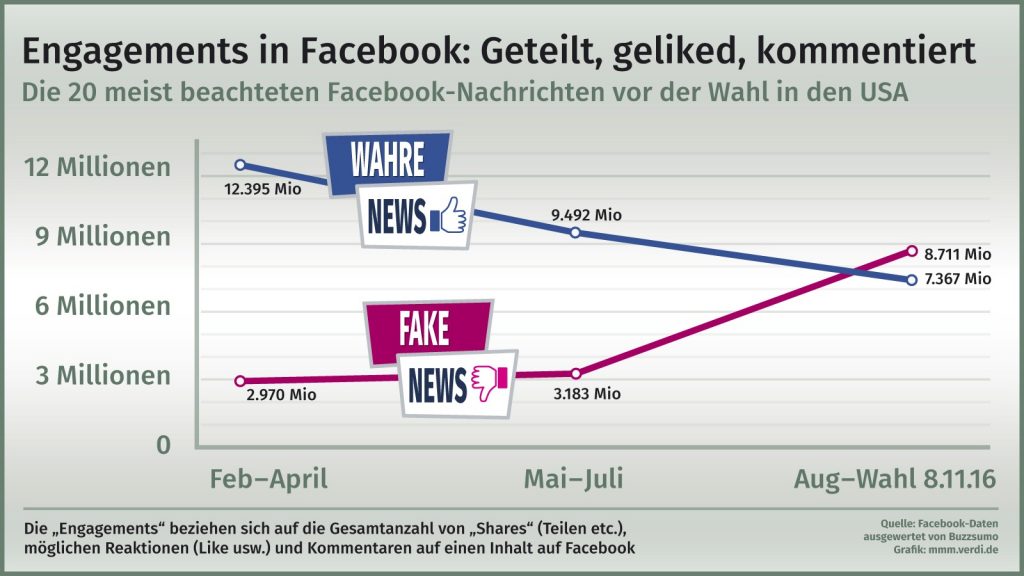

Die Analysen zum Thema Fake News sind alarmierend, aber alles andere als eindeutig. So veröffentlichte Buzzfeed im November eine Statistik, wonach in den Wochen vor der US-Wahl auf sozialen Netzwerken die populärsten Fake News eine größere Verbreitung fanden als die meistgelesenen echten Nachrichten.  Zu ähnlichen Ergebnissen kommt eine Untersuchung der Website vom Januar, in der insbesondere Meldungen zu Bundeskanzlerin Angela Merkel untersucht wurden. So bekam ein Beitrag über ein Selfie-Foto der Kanzlerin mit einem Flüchtling ganze 12000 Reaktionen auf Facebook. Die frei erfundene Falschmeldung, dass sich der Flüchtling als Terrorist entpuppt habe, erzielte hingegen mehr als 32000 Reaktionen.

Zu ähnlichen Ergebnissen kommt eine Untersuchung der Website vom Januar, in der insbesondere Meldungen zu Bundeskanzlerin Angela Merkel untersucht wurden. So bekam ein Beitrag über ein Selfie-Foto der Kanzlerin mit einem Flüchtling ganze 12000 Reaktionen auf Facebook. Die frei erfundene Falschmeldung, dass sich der Flüchtling als Terrorist entpuppt habe, erzielte hingegen mehr als 32000 Reaktionen.

Fake News

sind erfundene oder grob irreführende Meldungen, auch direkte Lügen, die verbreitet werden, um Besucher_innen anzuziehen und um die politische Stimmung zu beeinflussen. Der Begriff wird kritisiert, weil er schwer von irrtümlichen Falschmeldungen zu trennen ist.

Der deutsche IT-Branchenverband Bitkom warnt davor, das Fake News-Problem zu überschätzen. So verweist der Verband auf eine Umfrage, wonach zwei Drittel der Befragten schon Fake News bemerkt haben, aber nur eine kleine Minderheit hat sie geteilt. Die große Mehrheit der Befragten informiere sich weiterhin über etablierte Medien.

Vom E-Mail-Skandal zu „Pizzagate”

Woher kommt der plötzliche Hype um Fake News? Websites, die Verschwörungstheorien und Falschmeldungen verbreiten, gehören seit jeher zum Alltag im Internet. Neue Mechanismen der Nachrichtenverbreitung haben jedoch dafür gesorgt, dass sie nicht mehr nur Nischenpublikum erreichen, sondern Teil des gesellschaftlichen Diskurses werden.

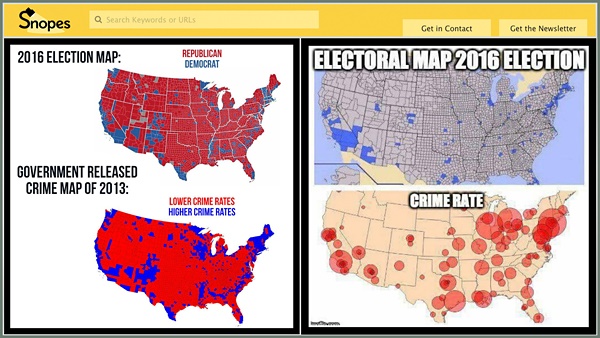

Die untere Karte links zeigt keine Kriminalitätsrate, sondern die Wahlergebnisse nach Staaten von 2012. Der falsche Titel und die Karte der Wählerstimmen von 2016 suggerieren, dass die Kriminalitätsrate mit der politischen Meinung der Wähler korreliere.

Die rechte obere Karte zeigt die 146 Landkreise, wo die Hälfte der US-Bevölkerung wohnt. Sie zeigt Bevölkerungsdichten und hat nichts mit Wahlen zu tun. Die rechte untere Karte aus dem Jahr 2009 zeigt die Mordrate in US-Großstädten. Snopes.com untersuchte und publizierte diese Fakes.

Als Anschauungsbeispiel kann der E-Mail-Skandal um Hillary Clinton gelten. Dass die demokratische Präsidentschaftskandidatin in ihrer Zeit als US-Außenministerin gegen die Vorschriften der Amtsführung verstoßen hatte, indem sie private und dienstliche E-Mails über einen eigenen E-Mail-Server abwickelte, war bekannt und bereits eine Belastung für Clinton. Als Wikileaks an mehrere tausend E-Mails aus der Wahlkampfzentrale der Demokraten gelangte, änderte sich die Dynamik jedoch entscheidend.

Die E-Mails des Clinton-Wahlkampfleiters John Podesta waren – zumindest nach heutigem Kenntnisstand – per Internetangriff gestohlen worden. So erhielt der Polit-Manager im März 2016 eine E-Mail, in der er aufgefordert wurde, einen Link anzuklicken. Wegen eines Missverständnisses tat Podesta wie geheißen – und öffnete prompt die interne Kommunikation der Wahlkampfzentrale für den Angreifer.

Als die Daten schließlich zu Wikileaks gelangten, entschied sich der Chef der Organisation Julian Assange für eine möglichst schädliche Veröffentlichungsstrategie: Statt wie in vorhergehenden Projekten mit Journalist_innen zusammenzuarbeiten, um nach tatsächlichen Verfehlungen Clintons zu suchen, veröffentlichte er die E-Mails stückweise über Wochen. Folge: Zahlreiche Medien berichteten ständig über die jeweils neuesten Enthüllungen. Zwar fanden die Journalist_innen keine Hinweise auf tatsächlich kriminelle Aktivitäten, aber allerhand schädliche Äußerungen, wie Auszüge aus bezahlten Reden Clintons, peinliche Enthüllungen über ihre Tochter Chelsey und Gefälligkeits-Wünsche von Spendern an Clintons private Stiftung.

Fanatiker und Profiteure

Die – teils exzessive – Berichterstattung zu den E-Mails bot ein ideales Umfeld für Websites, die sich auf die Verbreitung von Fake News spezialisiert hatten. Sie nutzten die Aufmerksamkeit zu Clintons E-Mails dazu, immer neue skandalträchtige Schlagzeilen zu generieren. Dafür übertrieben sie die Zusammenhänge entweder maßlos oder erfanden gleich Meldungen komplett neu.

Hier zeigten sich insbesondere zwei Abarten von Websites: Zum einen gibt es politisch motivierte Websites, die alles tun, um eine bestimmte Partei oder einen Kandidaten zu unterstützen. Gleichzeitig gibt es aber auch eine zunehmende Anzahl von Fake News-Sites, die aus reinen Profitgründen betrieben wurden. Oft nutzen diese Seiten Namen und Aufmachung etablierter Medien, um vom Renommee der Originale zu profitieren.

Bei den ersten Recherchen zum Fake News-Phänomen stellte sich heraus, dass viele dieser Websites aus einer kleinen Stadt in Mazedonien stammten. Die Betreiber hatten nicht vor, die US-Wahlen zu manipulieren, hatten aber festgestellt, dass die erfundenen Geschichten durch die massenhafte Verbreitung auf Facebook erhebliche Werbeumsätze generieren konnten.

Ihnen kamen Werbenetzwerke zu Hilfe, die ohne Rücksicht auf den Inhalt Werbung ausspielen. Zwar werden solche Anzeigen nicht sehr gut bezahlt, aber die massenhafte Verbreitung der billig produzierten Geschichten machten Fake News zum lohnenden Geschäft.

Die Fake News-Sites standen im regen Austausch mit Internet-Foren, wie Reddit, 4Chan oder geschlossenen Facebook-Gruppen, in denen politisch Fanatisierte und Trolle die Geschehnisse des Tages weitersponnen. Besonders berüchtigt ist die als „Pizzagate” bekannte Verschwörungstheorie: Weil sich in den von Wikileaks veröffentlichten E-Mails öfters Hinweise auf Pizzabestellungen in einem bestimmten Restaurant in Washington fanden, vermuteten Clinton-Gegner dort illegale Machenschaften. Aus unerfindlichen Gründen entstand das Gerücht, dass im Keller dieser Pizzeria ein Kinderprostitutionsring unter Kontrolle demokratischer Politiker sein Unwesen treibe. Diese Theorie gewann erstaunliche Popularität. Sie war auch nicht aus der Welt zu schaffen, als die Polizei das Restaurant untersuchte und feststellte, dass es überhaupt keinen Keller und somit dort auch keine Kinderprostituierten gab. Ein besonders fanatisierter Verschwörungstheoretiker stürmte gar mit einem Sturmgewehr im Anschlag die Pizzeria, um die Kinderprostituierten zu befreien, von denen er im Internet gelesen hatte.

Selbst dieser Vorfall zerschlug das Gerücht nicht. So forderte der vorher für den russischen Staatssender RT America tätige Moderator Ben Swann bei seinem neuen Arbeitgeber CBS46 nach der Wahl überraschend neue Untersuchungen zu dem vermeintlichen Skandal – allerdings wählte er ein anderes Restaurant als vermeintlichen Ort der gänzlich hypothetischen Verbrechen. Kernstück der Beweisführung: Ein altes Logo des Geschäftes erinnerte entfernt an ein Zeichen, das einst von einem Pädophilen-Netzwerk genutzt worden war. Swann nutzte den Bericht, um seine Kanäle auf Facebook und YouTube populärer zu machen. Gleichzeitig sammelte er Geld für seine nächsten Videos. Erst nach massivem Protest löschte CBS46 das Video und verordnete seinem Angestellten eine Unterbrechung seiner Aktivitäten in sozialen Netzwerken. Für Anhänger der Pizzagate-Theorie ist dies freilich nur ein weiterer Beweis, dass die Medien hier die Wahrheit verbergen wollen.

Algorithmen spalten

Wie kann es zu einer solch hartnäckigen Verschwörungstheorie kommen? Ein Faktor bei dieser radikalen Polarisierung sind sicher die Facebook-Algorithmen, die versuchen den „Newsfeed” seiner Mitglieder gemäß ihrer Vorlieben zu gestalten. Wer sich politisch eher links oder konservativ verortet, bekommt bevorzugt Nachrichten, die seinem politischen Standpunkt entsprechen. Wer jedoch komplett eine extreme Meinung vertritt, bekommt einen Meldungsmix präsentiert, der sich kaum noch mit der Realität anderer Menschen überschneidet.

Das „Wall Street Journal“ hat zur Illustration dieses Problems eine Website angelegt, die jeweils zeigt, welche Nachrichten extrem linke oder extrem rechte Nutzer_innen zu einem bestimmten Thema auf Facebook sehen. Während derzeit auf der linken Seite hämische bis panische Meldungen über die Aktivitäten Donald Trumps dominieren, werden auf der rechten Seite seine vermeintlichen Erfolge gefeiert. Lediglich eins ist beiden Extremen gemein – sie betonen gerne, dass die jeweils andere Lager Fake News verbreite. Mehrere Journalist_innen probten den Effekt, den diese Kanonade an unzuverlässigen Meldungen auf die Leser_innen macht. Betroffene sprechen davon, dass sich das komplette Weltbild innerhalb relativ kurzer Zeit verschieben kann. Informationen, die der eigenen Überzeugung entgegenstehen, werden meist ignoriert.

Persönlichkeitsprofile zur Manipulation

Der Facebook-Stream lässt sich aber auch gezielt zur Meinungsmanipulation von außen einsetzen. So machte die britische Firma Cambridge Analytica mit dem Anspruch Schlagzeilen, den Wahlsieg Trumps mit Hilfe von Big Data-Techniken herbeigeführt zu haben.

Timeline oder Facebook-Stream

spiegeln die Abfolge von Nachrichten, die auf den so genannten sozialen Plattformen an die Nutzer_innen ausgeliefert werden. Während Twitter die Beiträge chronologisch anzeigt, sortiert Facebook die Nachrichten nach vermuteter Relevanz und mischt Empfehlungen und Werbungen darunter.

Auch wenn die weitgehenden Ansprüche von Cambridge Analytica in der Fachwelt bezweifelt werden, ist die Grundtechnik valide. Mit Informationen aus sozialen Netzwerken wie der Vernetzung eines Profils können mit mathematischen Modellen Persönlichkeitsprofile erstellt werden, die Informationen offenbaren, die die Nutzer_innen gar nicht auf Facebook veröffentlicht haben. Zwar ist die Methode nicht überaus akkurat, aber durch die millionenfache Anwendung, lohnt sich die Big-Data-Anwending. So behauptet Cambridge Analytica mit 88-prozentiger Genauigkeit Homosexuelle identifizieren zu können, selbst wenn diese ihre sexuelle Orientierung nicht angeben.

Offen ist die Frage, ob Fake News dem Wahlkampf in den USA eine neue Brisanz verliehen haben, oder ob sie selbst eher Symptom einer schon vorher durch und durch polarisierten Medienlandschaft sind, die sich schon vor dem Erstarken Facebooks zunehmend an Extrempositionen abarbeitete, in der Politiker_innen wie die ehemalige Vizepräsidentschaftskandidatin Sarah Palin keine Gelegenheit auslassen, um über die „lamestreet media” zu polemisieren.

Was tun gegen Manipulation?

Die große Frage ist nun: Was soll man gegen die manipulative Meinungsmache unternehmen? Insbesondere vor der Landtagswahl in Nordrhein-Westfalen und der anschließenden Bundestagswahl machen sich deutsche Politiker und Medien Sorgen um breit angelegte Manipulationen. So hatte der 2015 bekannt gewordene Hacker-Angriff auf die Computer im Bundestag die Gesetzgeber nachhaltig irritiert. Bundesnachrichtendienst und Bundesamt für Verfassungsschutz haben bisher keine Beweise für eine organisierte russische Desinformationskampagne gefunden, die die US-Geheimdienste in den USA beklagen.

Bundesinnenminister Thomas de Maizière brachte bereits im Dezember 2016 ein „Abwehrzentrum gegen Desinformation“ ins Gespräch – und erntete breite Kritik. Dass eine staatliche Behörde zwischen echten und falschen Nachrichten unterscheiden soll, wurde weithin abgelehnt, der Plan wurde als „Wahrheitsministerium” verspottet. Inzwischen ist das Vorhaben wieder vom Tisch. Die SPD will die Betreiber sozialer Plattformen dazu verpflichten, binnen 24 Stunden offensichtliche Falschmeldungen zu löschen und dazu ein Gegendarstellungsrecht zu etablieren.

Die US-Konzerne versuchen unterdessen mit eigenen Initiativen Fake News loszuwerden oder zumindest einzudämmen. So warfen Google, Facebook und andere Anbieter die schlimmsten Fake News-Seiten aus ihren Werbenetzwerken, so dass die Betreiber kein Geld mehr damit verdienen können.

Mit einer weiteren Initiative versucht Facebook Nachrichten direkt auf seiner Plattform als Fälschungen entlarven zu lassen. So arbeitet der Konzern in den USA mit Publikationen wie ABC News und der Nachrichtenagentur Associated Press zusammen, um falsche Nachrichten richtigzustellen. Dabei obliegt es den Nutzer_innen Fake News zu melden, die dann anschließend von den Journalist_innen der Kooperationspartner überprüft werden. Stellt sich eine Nachricht als falsch oder grob irreführend heraus, wird diese auf Facebook nicht automatisch gelöscht, sondern als Fake News markiert und eine Korrektur angefügt.

In Deutschland soll das Recherchebüro Correctiv als erster Partner Facebook-Nachrichten überprüfen. Allerdings handelt es sich um ein Experiment mit unklarem Ausgang. So bezahlt der US-Konzern den Journalist_innen zunächst nichts für ihre Recherchearbeit, Correctiv finanziert sich über Spenden. Ob die Maßnahme tatsächlich den Strom ständig neuer Falschmeldungen stoppen kann, ist fraglich. Gleichzeitig überlegt der Konzern seine durch die Aktion gewonnenen Erkenntnisse in seine Timeline-Algorithmen zu integrieren, so dass Fake News in Zukunft weniger prominent angezeigt werden.

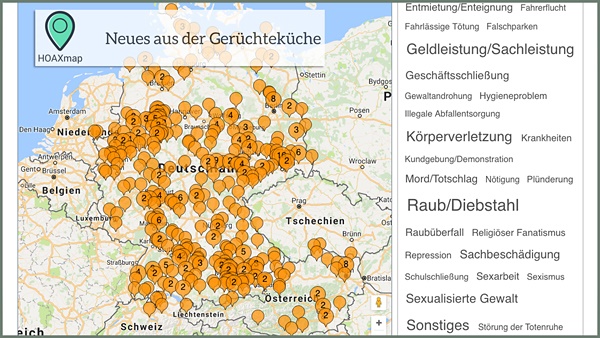

Unterdessen ist der Kampf gegen Fake News in Deutschland eine Sache von Einzelkämpfern. So hat die Initiative Hoaxmap inzwischen über 450 ausländerfeindliche Falschmeldungen gesammelt und auf einer Karte von Deutschland und Österreich arrangiert. Hierbei setzt die Initiative auf die Rechercheergebnisse von Journalist_innen, die aufgeregten Meldungen von Massenvergewaltigungen und Waffenlagern nachgehen und sie widerlegen.

Etwas breiter aufgestellt ist das Portal mimikama.at des österreichischen Vereins „Zuerst denken – dann klicken”. 15 ehrenamtlich arbeitende Nutzer_innen gehen hier Falschmeldungen aller Art nach – vom angeblich vergifteten Hundefutter bis zum WhatsApp-Kettenbrief.

Der öffentliche Rundfunk könnte eine Rolle bei der Bekämpfung der Falschinformationen spielen. So stellt der Bayerische Rundfunk ein Team zur Verifizierung von Nachrichten zusammen. Die Korrekturen sollen auch über eine Browser-Erweiterung verbreitet werden. Wie das aussehen könnte, zeigt ein Experiment der Washington Post, das den Twitter-Nachrichten des US-Präsidenten automatisch eine redaktionelle Korrektur entgegenstellt. Auch bei ARD aktuell in Hamburg soll laut Medienberichten eine Redaktion gegen Fake-News angesiedelt werden.

Politischer Aktionismus gegen Bots

Die Politik konzentriert sich unterdessen auf ein weiteres Mittel der Desinformation. So forderte die Bundestagsfraktion der Grünen im Januar eine Transparenz- und Anzeigepflicht für sogenannte Social Bots. Die Programme, die automatische Meldungen in sozialen Netzwerken absetzen können, hätten den öffentlichen Diskurs geschädigt: „Sie täuschen vermeintliche Mehrheitsverhältnisse vor, die real nicht bestehen, und beeinflussen verdeckt demokratische Entscheidungsprozesse, ohne dass dies für die Empfänger_innen der Bot-Botschaften erkennbar wäre”, heißt es in dem Fraktionsbeschluss.

Social Bots

sind Programme, die auf Plattformen wie Twitter oder Facebook automatisiert Aufgaben übernehmen. Redaktionen lassen ihre aktuellen Schlagzeilen von solchen Skripten verbreiten: Es gibt aber auch Spammer und politische Kräfte, die damit Meinungen manipulieren wollen. Meist verbreiten die Social Bots nur vorgefertigte Botschaften oder kopieren Nachrichten aus einer Quelle.

Social Bots haben aufgrund der Konstruktion sozialer Netzwerke nur beschränkte Wirkung. Die Programme können zwar relativ problemlos Twitter oder andere Plattformen mit Millionen Botschaften fluten. Doch die menschlichen Nutzer erfahren davon nichts, wenn sie den entsprechenden Accounts nicht folgen. Social Bots machen sich daher Hashtags zu Nutze, um sich in bestehende Konversationen einzuklinken. Dort müssen die politischen Social Bots aber mit einer Übermacht anderer Bots konkurrieren, die für zwielichtige Single-Börsen, Potenzmittel oder Porno-Seiten Werbung machen.

Menschen als bessere Social Bots

Hashtags

werden auch von Sozialen Netzwerken genutzt, um Beiträge zu organisieren. Dazu markieren die Nutzer_innen ihre Beiträge mit einem Stichwort, das mit einem einleitenden Doppelkreuz versehen wird – zum Beispiel „#Aufschrei“. Ein Klick auf das Wort zeigt alle Beiträge, die ebenfalls mit dem gleichen Hashtag verfasst wurden.

Die statistische Analyse hat dabei ihre Grenzen. So identifizierte Hegelich für eine ZDF-Reportage zwei Facebook-Profile, hinter denen er Programme mit Manipulierungsauftrag vermutete. Der Journalist Benedikt Walter ging dem Hinweis nach und stellte fest, dass einer der mutmaßlichen Social Bots tatsächlich ein Frührentner aus Leipzig war, der offenbar nur von seiner eigenen politischen Überzeugung getrieben wurde, tagtäglich Hunderte Beiträge anzuklicken und zu verbreiten.

Die AfD baut unterdessen darauf, ihre menschlichen Anhänger weiter aufzuschaukeln. So will die Partei gezielt Tabus brechen, um sich weiter ins Gespräch zu bringen, wurde in einem Strategiepapier enthüllt. So hatte die Partei auch mit der Erklärung provoziert, im Wahlkampf Social Bots einsetzen zu wollen. Nachdem diese Nachricht für Schlagzeilen gesorgt hatte, zog die Partei die Ankündigung kurzerhand wieder zurück.

Wie gut die mediale Provokation funktioniert, beweist der US-Präsident immer wieder. So behauptete Donald Trump, dass Medien gezielt Terroranschläge verheimlichten, um die öffentliche Meinung zu beeinflussen. Als Sender wie CNN diesem Vorwurf widersprachen, zeigten sie notgedrungen Bilder ihrer vergangenen Terror-Berichterstattung – und sorgten so beim Publikum für erhöhte Terror-Angst.

Kampf der Memes

Memes

sind ein popkulturelles Phänomen. Texte, Bilder, Videos und Slogans werden über Plattformen wie Twitter und Facebook verbreitet und ständig neu kombiniert oder weiterentwickelt.

Beispiel: Ein bei eher linken Nutzer_innen beliebtes Meme war die Begrüßung von Donald und Melania Trump durch die Obamas bei den Feierlichkeiten zur Amtseinführung des neuen Präsidenten. Während Donald Trump seine Frau ignorierte und zügig auf seinen Vorgänger zuging, wurde Melania Trump von den Obamas betont freundlich empfangen und in die Mitte genommen. Kritiker Trumps bewerteten die Szene als Beleg für dessen Untauglichkeit. Die Szene wurde immer wieder neu zusammengeschnitten und verbreitet.

Trump-Anhänger wiederum änderten die eindrückliche Szene per Photoshop. In der bearbeiteten Version sah es so aus, als ob der US-Präsident der Frau seines Nachfolgers an den Po gefasst habe. Auch diese Version wurde begeistert geteilt – diesmal vom anderen Lager. Taucht das Bild nun in dem Facebook-Feed eines konservativen Nutzers auf, hat er kaum Chancen sich des beabsichtigten Eindrucks zu entziehen.

Dass solche Meme nicht nur banaler Zeitvertreib sind, zeigte Buzzfeed in einer weiteren Reportage. Der Reporter Ryan Broderick war auf eine geheime Gruppe von Trump-Fans gestoßen, die die Beeinflussung der französischen Präsidentschaftswahl planten. Ihr Mittel: Sie basteln nach dem Baukastenprinzip ständig neue Spottbilder über Gegner Marine Le Pens, die sie über zahlreiche gefälschte Accounts bei Twitter und Facebook verbreiten. Das Kalkül: Andere Nutzer sollen die Motive übernehmen und damit den Eindruck erwecken, dass eine breite Mehrheit der Bevölkerung die Kritik teilen.

Ob die im US-Wahlkampf erprobten Techniken auch in Europa fruchten, muss sich allerdings noch erweisen. Unterdessen versucht die SPD, die Macht der Meme für sich einzusetzen. So wurde auf der sozialen Plattform Reddit eine eigene Untergruppe für den Kanzlerkandidaten Martin Schulz gegründet, in der der Politiker mit ironisch-überschwänglichen Parolen als „Gottkanzler” gefeiert wird. Der Politiker reagierte mit einem Grußwort auf YouTube und bedankte sich für die „Fantasie, die richtig Spaß macht”.

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf den Button unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Für die Fake News-Schreiber ist diese Popularität natürlich auch eine Einladung. Prompt wurde dem SPD-Politiker auf Facebook unterstellt, den zynischen Satz: „Der Tod von einigen Deutschen ist ein kleiner Preis für die Sicherheit tausender Syrer” verbreitet zu haben. Natürlich ist das Zitat reine Erfindung und wurde vorher bereits Politikern wie Renate Künast, Stefanie von Berg und Sigmar Gabriel angedichtet. Welche Art von Memen in den kommenden Monaten die Überhand gewinnt, bleibt abzuwarten.